고성능, 딥 러닝 추론 배포

OpenVINO™ 툴킷의 인텔 배포 툴®킷의 최신 버전(2022.1)을 사용하면 모든 곳의 개발자가 더 쉽게 제작을 시작할 수 있습니다. 이는 툴킷이 처음 출시된 이후 가장 큰 업그레이드이며 더 적은 코드 변경으로 더 많은 딥 러닝 모델, 장치 이식성 및 더 높은 추론 성능을 제공합니다. 추론에 최적화된 Open Model Zoo의 사전 학습된 모델을 빠르게 시작하세요. 툴킷은 가장 인기있는 프레임 워크와 호환되므로 중단이 최소화되고 성능이 극대화됩니다.

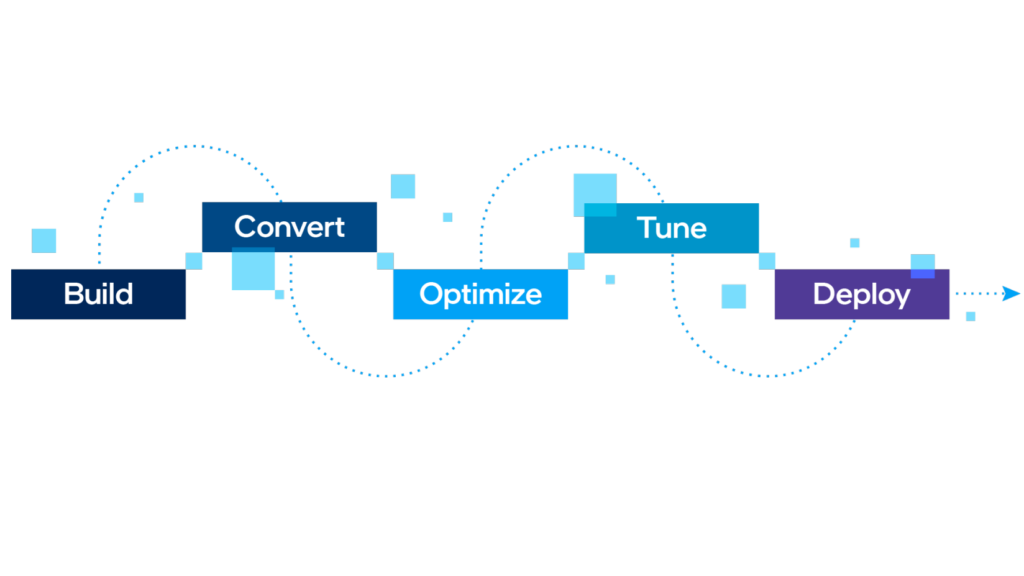

AI 배포를 처음부터 끝까지 최대한 활용하십시오.

OpenVINO 툴킷을 사용하면 코드를 간단하게 채택하고 유지 관리할 수 있습니다. Open Model Zoo는 최적화되고 사전 학습된 모델을 제공하며 모델 최적화 도구 API 매개 변수를 사용하면 모델을 쉽게 변환하고 추론을 준비할 수 있습니다. 런타임(추론 엔진)을 사용하면 최적화된 네트워크를 컴파일하고 특정 장치에서 추론 작업을 관리하여 성능을 조정할 수 있습니다. 또한 장치 검색, 부하 분산 및 CPU, GPU 등에서 병렬 처리를 추론하여 자동으로 최적화합니다.

고성능, 딥 러닝

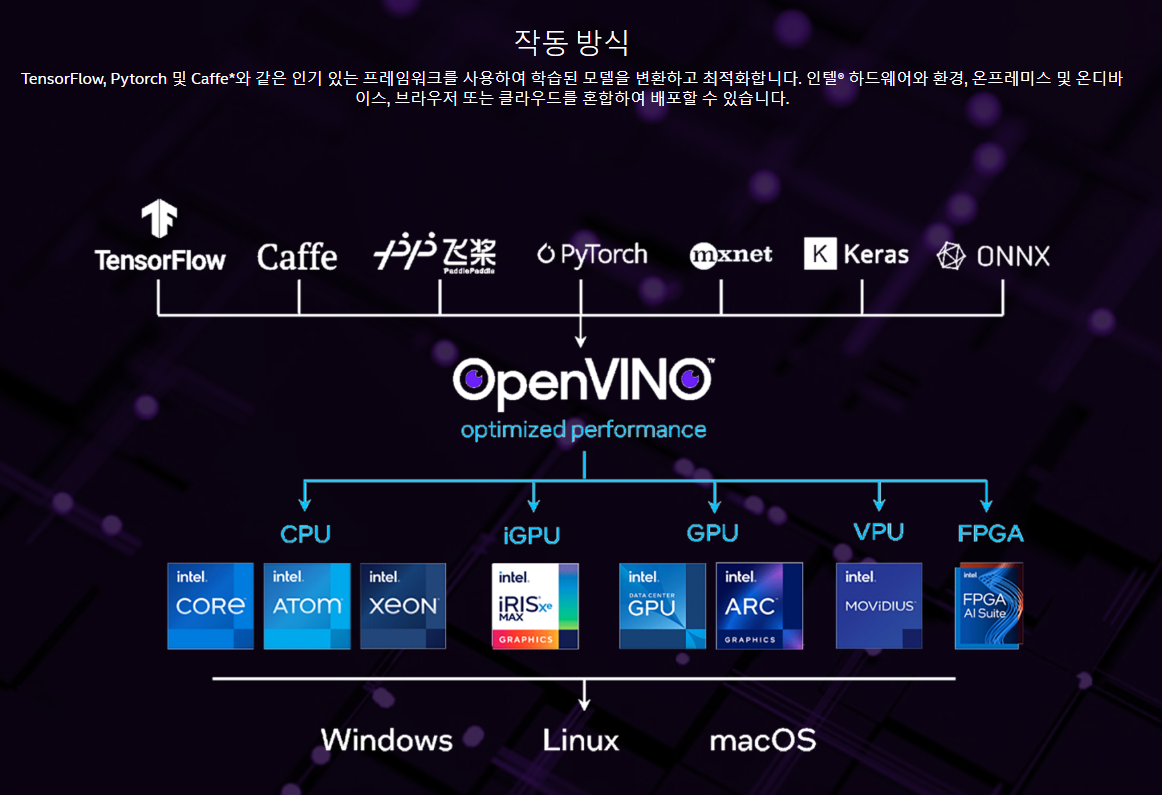

TensorFlow* 및 PyTorch*와 같은 일반적인 프레임워크부터 시작하여 OpenVINO 툴킷용 NNCF(신경망 압축 프레임워크)를 활용하여 추론을 염두에 두고 학습합니다.

간소화된 개발

사후 교육 양자화 및 최적화를 위해 사후 교육 최적화 도구를 사용하여 모델을 OpenVINO로 가져옵니다.

한 번 쓰기, 어디서나 배포

호스트 프로세서와 가속기(CPU, GPU, VPU) 및 환경(온-프레미스, 온디바이스, 브라우저 또는 클라우드)의 조합에 동일한 애플리케이션을 배포합니다.

기능 살펴보기 및 시작하기

딥 러닝을 민주화하고 OpenVINO로 새로운 창의력의 물결을 펼치십시오. 학습하고, 샘플을 시험해보고, 성능을 확인하고, 인증을 받는 데 필요한 리소스를 자신의 데스크톱 또는 노트북에서 시작하세요.

주문형 Webinars 보기

intel의 AI 전문가 팀은 몇 분 안에 AI 응용 프로그램을 실행하는 방법을 보여줍니다.

툴킷 애드온

OpenVINO 툴킷의 가능성을 확장하는 추가 기능을 활용하고 핵심 툴킷에서 현재 사용할 수 있는 기존 및 새로운 기능을 구현하십시오.

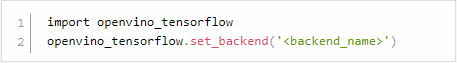

OpenVINO™ Integration with TensorFlow*

향상된 수준의 TensorFlow 호환성을 위해 OpenVINO 툴킷의 인라인 최적화 및 런타임을 사용하십시오. 다음 두 줄의 코드를 Python* 코드 또는 Jupyter* 노트북에 추가합니다.

다음과 같은 다양한 인텔® 실리콘에서 많은 AI 모델에서 추론을 가속화합니다.

intel® CPU

intel의 통합 그래픽

intel® 모비디우스™ 비전 프로세싱 유닛(VPU)

여덟 개의 인텔 모비디우스™ 무수한™ X VPU를 갖춘 intel®® 비전 가속기 설계

성공 사례

커뮤니티 및 지원

다양한 방법으로 참여하고 최신 공지 사항을 최신 상태로 유지하십시오.